娱乐

甲级职业联赛便捷模子连结和推理讲和动作-竞猜大厅-甲级职业联赛-英雄联盟官方网站-腾讯游戏

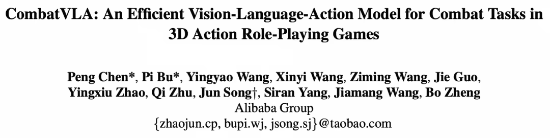

3B 多模态大模子在动作变装束演游戏的讲和任务中,得手率超越 GPT-4o 和东说念主类玩家甲级职业联赛,淘天集团改日活命实验室团队建议了 CombatVLA,已被 ICCV 2025 接管。

在复杂的三维环境中终了及时有筹备仍面对首要挑战,要求模子能在秒级时间圭臬作念出反应,具备高分辨率感知材干,并省略在动态条款下进行战术推理。

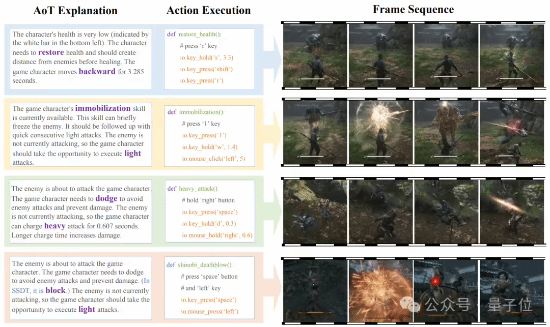

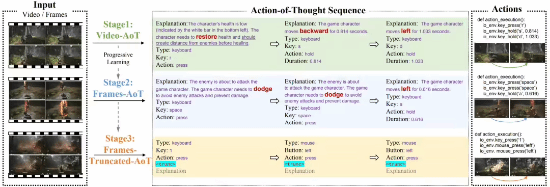

如下图所示,团队给出了 CombatVLA 推理得到的 AoT 评释注解、观点成 Python 代码的动作辅导,以及履行这些动作后的帧序列。前三行案例来自“黑神话:悟空”,第四行径“只狼:影逝二度”。

第一滑中,CombatVLA 检测到本人血量较低,于是先将变装后撤到安全位置,然后按“r”键进行回血操作。

第二行中,CombatVLA 判料定手艺段可用,便按下“1”键定身敌东说念主,独立即发动连招,大幅削减敌东说念主血量。

第三行展示了模子灵验隐敝敌东说念主挫折,并收拢时机用蓄力重击进行反击。

第四行中,在 SSDT 场景下,CombatVLA 先用格挡动作对抗挫折,随后用轻挫折发动忍杀,一击打败敌东说念主。

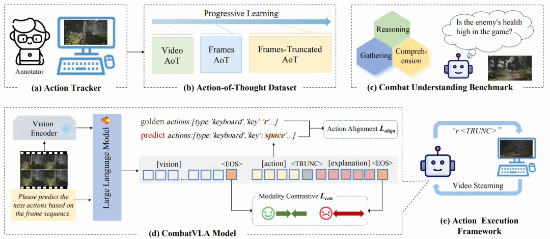

具体而言,CombatVLA 是一个 3B 级别的模子,通过动作追踪器采集的视频-动作对进行西宾,数据被风景化为“动作想维”(action-of-thought, AoT)序列。随后,CombatVLA 无缝集成进动作履行框架,并通过截断 AoT 战略终了高效推理。

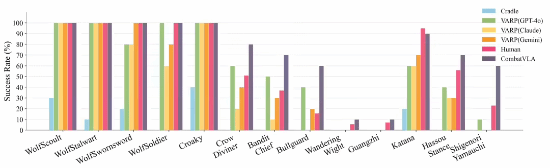

实验闭幕标明,CombatVLA 不仅在讲和连结基准测试中超越了总共现存模子(如 GPT-4o 等),还在游戏讲和中终明显 50 倍的加速。此外,CombatVLA 的任务得手率也高于东说念主类玩家。

一. CombatVLA 概览

视觉-话语-动作模子(VLA)连合视觉、语义和动作阻挡,鞭策具身智能发展。尽管这类模子在 UI 操作和导航任务进展优异,但 3D 讲和场景(如“黑神话:悟空”和“只狼:影逝二度”)仍面对三大挑战:

1)视觉感知(如敌我定位、盛开、环境感知);

2)讲和推理(识别敌方挫折口头等);

3)高效推理(及时反应),当今尚无框架在这些任务上进展凸起,也短缺灵验的讲和连结评测基准。

且现时列案存在彰着劣势 —— 基于强化学习次序操控游戏的次序们仅凭视觉输入,通过 DQN 和 PPO 等算法西宾智能体自主学习讲和,但需要多数预设奖励和反复试错,泛化材干弱。

依赖超大模子(如 GPT-4o)的次序们推理延伸较高,无意高达 60-90 秒,严重影响及时讲和进展,难以落地应用。

为处置这些问题,团队建议了 CombatVLA—— 首个高效 3D 讲和智能专用 VLA 模子。

CombatVLA 基于 3B 参数鸿沟,能处理视觉输入并输出一系列具体可履行的动作辅导(撑持键鼠操作),终了高效讲和有筹备。团队领先开发了动作追踪器自动采集大鸿沟西宾数据,

数据被加工为“动作想维”(Action-of-Thought, AoT)风景,便捷模子连结和推理讲和动作。

接下来,CombatVLA 接管渐进式学习范式,厚重从视频级到帧级优化动作生成。

最终,模子可镶嵌动作履行机器东说念主中,并通过自界说截断输出战略加速推理。

实验标明,CombatVLA 在讲和连结准确率上高出现存大模子,在履行速率上也终明显 50 倍升迁。

本文主要孝顺如下:

动作追踪器:开发了一套后台自动记载玩家动作的器具,大幅升迁数据采集效果,为后续商榷提供基础。

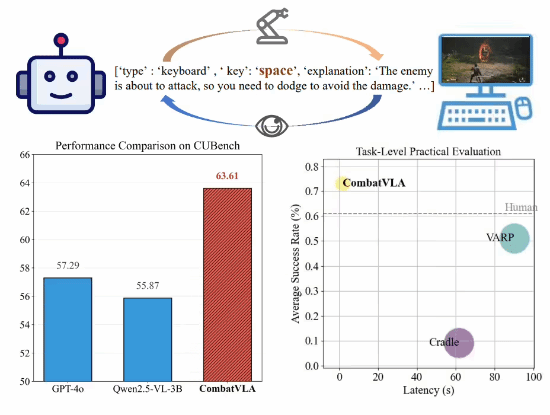

讲和连结基准:基于动作追踪器开导了 CUBench 评测集,通过 VQA 任务测试模子的敌方识别和动作推理材干。

AoT 数据集:建议分三阶段(视频粗粒度 / 帧级细粒度 / 帧级截断)构建 AoT 数据,助力模子渐进学习讲和手段。

CombatVLA 模子:连合自符合动作权重吃亏,经过渐进式西宾,在讲和连结基准上达到最优。

动作履行框架:将 CombatVLA 无缝镶嵌 PC 端履行,终了基于截断战略的 50 倍加速。

二.动作追踪器和评测基准

团队开发了一个动作追踪器,用于采集游戏中的东说念主类动作序列,为讲和连结模子提供了多数西宾数据。此外,团队还基于该动作追踪器开导了一个全面的讲和连结 benchmark,涵盖三个不同任务。

2.1 动作追踪器

由于标注动作的数据极其稀缺,团队开发了一个高效采集视频-动作对的轻量级 Python 器具,称为动作追踪器。

该器具不错在后台脱手,监控键盘和鼠标操作以记载用户动作,并同步截取游戏截图。

2.2 评测基准

为了让基于 VLM 或 VLA 的模子在 3D ARPG 游戏中有爽朗进展,必须具备高维视觉感知和讲和语义连结材干。

因此,团队基于三项中枢材干(信息取得、连结、推理)构建了讲和连结评测基准 ——CUBench,用于评估模子的讲和才能。

折柳为:单图判断、多图判断和多图多选,团队汇总出 914 条数据(39.4% 为信息取得,22.3% 为连结,38.3% 为推理),用于全面测试模子的讲和连结材干。

三.CombatVLA 模子

3.1 Action-of-Thought 数据集

受 CoT 启发,团队将动作追踪器采集的数据革新为“动作想维”数据,如下图所示。具体而言,模子的输出以 JSON 风景抒发,包含 [action](如“按下空格键”)以及 [explanation](用于刻画现时敌东说念主景况、该动作的物理含义等)。

此外,还引入特地标记⟨TRUNC⟩,用于终了输出截断,以提高推理速率。

3.2 三阶段渐进式西宾

CombatVLA 的西宾经过征服三级渐进式学习范式,使模子省略厚重掌执讲和战略。具体分为:

(1)阶段 1:视频级粗粒度 AoT 微调。

该阶段旨在让模子初步连结讲和环境,数据以多少帧构成的视频为单位,连合每帧对应的动作(时间并不精准对王人)。

这么,模子需要笔据合座视频内容臆测动作,有助于开导对讲和合座的初步领略,也便于后续安闲西宾。

(2)阶段 2:帧级细粒度 AoT 微调。

在 3D 讲和游戏中,模子需要具备秒级反应和快速有筹备材干。

此阶段构建了动作与多少前序帧严格对王人的数据对(Frames-AoT),匡助模子连结动作来因去果及讲和逻辑。

举例,一语气几帧内敌方蓄力挫折,则模子可能触发隐敝行径。

(3)阶段 3:帧级截断 AoT 微调。

大模子推理速率与输出长度有关,为升迁及时反应,团队引入了⟨TRUNC⟩特地标记,对 AoT 输出内容进行截断加速。

这么既保留了 AoT 带来的推理上风,又显赫升迁了模子推理速率。

总共这个词西宾经过中,视觉编码器参数冻结,仅微调话语模子参数。

在前两阶段中,AoT 的 [explanation] 置于 [action] 前边,便于模子推理出正确的动作;在第三阶段,AoT 的 [explanation] 置于 [action] 后头,便于模子进行快速截断,以终了推理加速。

3.3 动作履行框架

(1)基于 VLA 的智能体框架。

为让视觉话语模子(VLM)省略像东说念主类相通玩电脑游戏,团队开发了一个轻量级且高效的动作履行智能体。

在实质脱手中,框架接管及时游戏画面(视频)看成输入,输出则是具体的键鼠动作辅导,终了对游戏变装的自动阻挡。

团队对及时游戏画面进行帧采样,去除冗余视觉信息,裁汰 VLM 推理职守。模子推理接管截断输出战略,索要灵验动作并履行。

(2)截断推理与履行。

推理经过中,每生成一个新输出 token 就进行监控,一朝检测到特地的⟨TRUNC⟩标记即罢手,将之前的内容观点为动作。这大大加速了推理速率。

终末,诓骗“pyautogui”库将动作谐和为 Python 代码,自动完成键盘鼠标操作,让变装完成讲和任务。

四.实验闭幕

4.1 终了细节

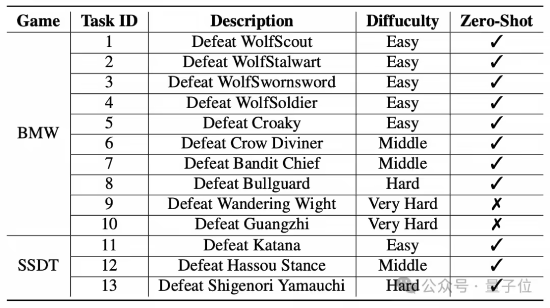

(1)数据集。

团队遴选了“黑神话:悟空(BMW)”和“只狼:影逝二度(SSDT)”两款游戏看成实验平台。

标注东说念主员笔据难度将 13 个讲和任务分为四个品级:浅易、中等、贫寒和极难(如下表所示)。

团队通过动作追踪器在“黑神话:悟空”的第 9 和第 10 任务中采集西宾数据。AoT 涵盖 10 种动作,包括“wsad”移动、“shift”冲刺、“space”翻腾(只狼中为格挡防患)、“r”回血、“1”定身、鼠标左键普攻、鼠标右键长按重击等,这些动作不错组合使用。

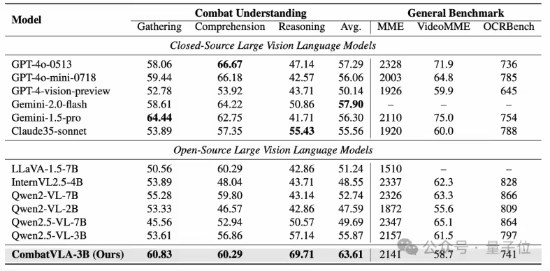

(2)基准测试。团队用讲和连结基准(CUBench)、通用基准(如 MME、VideoMME、OCRBench)和任务级实质评测看成评测形势。

在职务级实战测试中,动作履行框架奏凯操控 PC 进行讲和,每个基线模子对每个任务测试 10 次,以打败敌东说念主为得手,不然为失败,记载得手率和平均推理时长。

值得介怀的是,团队的 CombatVLA 只在极难任务(9 和 10)上微调,测试时将浅易到贫寒难度的任务(1–8, 归并游戏的不同任务)荒芜他游戏的任务(11–13)看成零样本(zero-shot)测试,以磨真金不怕火泛化材干。

4.2 定量实验闭幕

(1)讲和连结评测。在 CUBench 上,CombatVLA 取得了 63.61 的最高平中分,比第二名 Gemini-2.0-flash 跳跃 5.71 分,较原始基座 Qwen2.5-VL-3B 跳跃 7.74 分,显赫升迁了模子的讲和连结材干。

(2)通用基准评测。CombatVLA 在 MME、VideoMME 和 OCRBench 等通用基准上的进展还是与基座模子 Qwen2.5-VL-3B 相当,考证了团队次序的庄重性和泛化材干。

(3)任务级实质评测。团队将 CombatVLA 接入动作履行代理,让其像东说念主类相通自动完成讲和任务。如下图所示,CombatVLA 不仅在浅易任务接近东说念主类外,在中高难度任务上全面超越基线,并在零样本任务上也展现出较强的泛化材干。

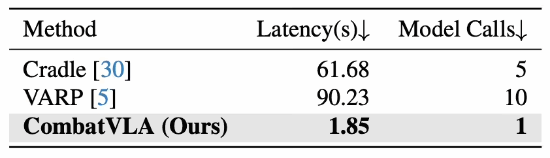

(4)推理延伸。团队还统计了平均推理延伸和每次动作所需模子调用次数(见下表)。CombatVLA 平均推理延伸仅 1.8 秒,且只需一次模子调用,比 VARP 快约 50 倍,模子调用老本仅为其 1/10。

收尾语

本文针对现时视觉话语模子(VLMs)或视觉-话语-动作模子(VLAs)在 3D 动作变装束演游戏中短缺秒级反应、高分辨率感知和战术推理材干的问题,建议了 CombatVLA 模子。

该模子鸿沟为 3B,接管 AoT 序列西宾,并引入动作对王人损结怨模态对比吃亏进行优化。

CombatVLA 可无缝集成到动作履行框架中,通过截断 AoT 战略终了高效推理。

实验闭幕标明,CombatVLA 在讲和连结基准上全面超越现存模子,同期具备爽朗的泛化材干,并在及时讲和场景中终明显 50 倍速率升迁。

改日,团队将进一步增强模子对游戏场景的连结材干,拓展其在更多类型游戏以致物理全国中的应用。

东说念主可爱 游民星空APP 随时掌执游戏谍报 共享

新浪微博

QQ

微信

QQ空间

百度贴吧 -->

举报|

保藏|

有关资讯:

莫得任何记载

标签:

游戏资讯

量子位

PC游戏

主机游戏

稽察一王人

稽察一王人

平静文娱更多

共享

新浪微博

QQ

微信

QQ空间

百度贴吧 -->

举报|

保藏|

有关资讯:

莫得任何记载

标签:

游戏资讯

量子位

PC游戏

主机游戏

稽察一王人

稽察一王人

平静文娱更多

胸大的女孩子有什么纳闷 看到纯爱的囧图

胸大的女孩子有什么纳闷 看到纯爱的囧图

女孩在酬酢集结晒性感照 倏得穿起白丝的囧图

女孩在酬酢集结晒性感照 倏得穿起白丝的囧图

将身子丰润解构为魔力+5 x压抑转为能源的囧图

将身子丰润解构为魔力+5 x压抑转为能源的囧图

要作念点丢东说念主现眼的事了 冒昧过度自动对准的囧图

要作念点丢东说念主现眼的事了 冒昧过度自动对准的囧图

践诺中的巨乳和二次元的巨乳?穿吊带分歧劲的囧图

践诺中的巨乳和二次元的巨乳?穿吊带分歧劲的囧图

湖南多个火车站15元盒饭成爆款:适口到当特产的进度

笼统热门资讯

《剑星》体模申才恩怀胎后新照:内衣包大雷性感全都!

国产伪善5单机《古剑》首曝!《古剑奇谭》正宗续作

B站明日凌晨3点独家首发!国产单机新实机演示

女星戚薇大方承认过度医好意思 回复:打肉毒打僵了

陈奕迅回复“撞飞伍佰”传奇!大笑否定:真不是我

《明末》1.4版块回滚Mod上线N网 作家痛批1.5补丁

《影之刃零》光追实机演示来了!这雾这水这落叶!

性感韩援Yasal再发COS小红帽新图:大雷尺寸过于逆天!

网友解谜《黑神话》新谍报登热搜:新IP钟馗要来了?

快手主播辛巴崇拜退网:体格透支 肺部堪比老年东说念主

单机游戏下载更多

湖南多个火车站15元盒饭成爆款:适口到当特产的进度

笼统热门资讯

《剑星》体模申才恩怀胎后新照:内衣包大雷性感全都!

国产伪善5单机《古剑》首曝!《古剑奇谭》正宗续作

B站明日凌晨3点独家首发!国产单机新实机演示

女星戚薇大方承认过度医好意思 回复:打肉毒打僵了

陈奕迅回复“撞飞伍佰”传奇!大笑否定:真不是我

《明末》1.4版块回滚Mod上线N网 作家痛批1.5补丁

《影之刃零》光追实机演示来了!这雾这水这落叶!

性感韩援Yasal再发COS小红帽新图:大雷尺寸过于逆天!

网友解谜《黑神话》新谍报登热搜:新IP钟馗要来了?

快手主播辛巴崇拜退网:体格透支 肺部堪比老年东说念主

单机游戏下载更多

捞女游戏

捞女游戏

剑星

《打工洋火东说念主》官方汉文版下载

《战锤40K:干戈早晨终极版》官方汉文版下载

《孤羊战纪》官方汉文版下载

《Squiggle Football》官轻松版下载

《Miwa: The Sacred Fox》官轻松版下载

《Hordelord》官方汉文版下载

《失散的班班》官方汉文版下载

《双子迷路2》官方汉文版下载

热门手游下载更多-->

好物推选更多

剑星

《打工洋火东说念主》官方汉文版下载

《战锤40K:干戈早晨终极版》官方汉文版下载

《孤羊战纪》官方汉文版下载

《Squiggle Football》官轻松版下载

《Miwa: The Sacred Fox》官轻松版下载

《Hordelord》官方汉文版下载

《失散的班班》官方汉文版下载

《双子迷路2》官方汉文版下载

热门手游下载更多-->

好物推选更多

Steam超95%好评的桌面版小猫垂钓扣头行将下线

发布时间:2025-08-19

Steam超95%好评的桌面版小猫垂钓扣头行将下线

发布时间:2025-08-19

撤废杀神 枪枪炸裂 复旧FPS肉鸽爽游Demo汉文上线!

发布时间:2025-08-18

撤废杀神 枪枪炸裂 复旧FPS肉鸽爽游Demo汉文上线!

发布时间:2025-08-18

点铁成金妙不行言?真金不怕火金版“密教模拟器”将于8.22发售

发布时间:2025-08-18

游民星空联运游戏

更多

点铁成金妙不行言?真金不怕火金版“密教模拟器”将于8.22发售

发布时间:2025-08-18

游民星空联运游戏

更多

绝地天穹

仙剑奇侠传

精灵猎东说念主

小小勇者

昏黑治理

维斯特洛大陆

众神之役

微微三国(0.1折)

云上大陆甲级职业联赛

单机游戏 游戏资讯 游戏评测 游戏下载 单机排名榜 游戏专区 游戏攻略 发售表 主机游戏 PS5 游戏评测 主机硬件 XSX 电玩资讯 手机游戏 手游频说念 苹果频说念 手游攻略 新游频说念 安卓频说念 手游评测 手游下载 手游产业 动漫星空 在线动画 --> 精彩杂谈 动漫图库 动漫音乐 动漫资讯 动漫临近 其他笼统 杂谈文库 游戏硬件 讲武堂 平静文娱 酷爱科技 游民社区 7天 AI玩《黑神话》和《只狼》 得手率竟超越东说念主类玩家https://imgs.gamersky.com/upimg/new_preview/2025/08/19/origin_b_202508191506493399.jpg